Doba dezinformační

Obsah dílu

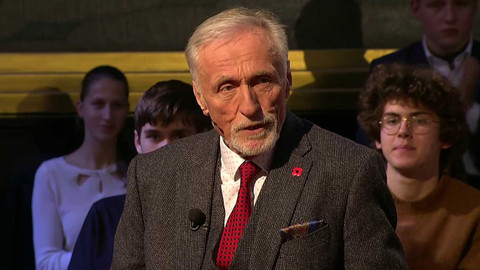

Složitý svět přeplněný informacemi. Jak se v nich vyznat? Jak odlišit fakta od výmyslů a lží? A komu prospívá informační chaos? Pozvání přijali armádní generál Petr Pavel, astronom Jiří Grygar, politický geograf Michael Romancov, politoložky Anna Durnová a Petra Vejvodová nebo analytik František Vrabel.

Části dílu

Přehled dílů

Návrat feudalismu

Peníze a moc: Jiří Rusnok a Jiří Dolejš — Příběh rodinné Podbrdské minimlékárny — Páni a poddaní: Ondřej Lánský a Ondřej Jonáš — Příběh rodinného brašnářství Facebag — Technofeudalismus: Jiří Pehe a Martin Tremčinský — Příběh rodinné sklárny Jílek — Návrat feudalismu

Veřejná služba

Občanská společnost: Katerina Demetrashvili a Matěj Gregor — Veřejné vysoké školy jako záruka svobody bádání: rozhovor s Janem Švejnarem — Svobodné bádání: Václav Bělohradský a Jan Komárek — Média veřejné služby: rozhovor s Jaromírem Volkem — Svobodná média: Zuzana Kovačič Hanzelová a Ivo Mathé — Dělají tradiční média dost, aby přitáhla mladou generaci?: názory studentů — Veřejná služba

Umění kompromisu

Kompromis v politice: Hana Kordová Marvanová a Mirek Topolánek — Emigrant Michael Kraus – nutnost a podoby kompromisu — Kompromis v dějinách: Jaroslav Šebek a Tomáš Petříček — Mluvčí Charty 77 Anna Šabatová — Kompromis v hlavě: Martina Viktore Voborníková Kopecká a Jan Vojtko — V čem se může a v čem nesmí ustupovat – názory studentů — Umění kompromisu

Hranice demokracie

Demokratické limity: Zuzana Roithová a Adriana Krnáčová — Studenti poprvé u voleb — Demokratické limity: Jan Kysela a Jacques Rupnik — Jaké problémy by podle studentů měli politici řešit především — Demokratický kapitalismus: Tomáš Sedláček a Filip Kostelka — Jak studenti vnímají politiku a politiky — Hranice demokracie

Konzervativci a liberálové

Politika: Markéta Gregorová a Filip Turek — Konzervativní, nebo liberální – názory studentů — Duše: Tereza Matějčková a Marek Vácha — Jsme si všichni rovni? – názory studentů — Byznys: Šárka Homfray a Miroslav Singer — Největší problémy dnešní společnosti – názory studentů — Konzervativci a liberálové

Síla Evropy

Síla politiky: Zuzana Čaputová a Miloš Vystrčil — Síla byznysu: Filip Matějka a Martin Vohánka — Poznámky Donalda Trumpa k Evropě — Síla demokracie: Igor Lukeš a Vojtěch Boháč — Hrozby pro evropskou i českou justici — Síla Evropy

Humor a politici

Humor a politici: Ester Pes Kočičková a Miroslav Kalousek — Ukázka z aktuální česko-slovenské komediální scény — Humor bez hranic: František Košarišťan a Tomáš Břínek alias TMBK — Komické situace z Poslanecké sněmovny — Obrana humorem: Martina Klicperová a Vladimír Just — Česká soda — Humor a politika

Globální tíseň

Strach z války: Iveta Radičová a Petr Fiala — Lékařka, psychoterapeutka ve výcviku a zakladatelka MedicRise Barbora Mechúrová — Strach z chudoby: Daniel Prokop a Eva Kotlánová — Zakladatel Nesnězeno Jakub Henni — Klimatická tíseň: Rozárie Haškovcová a Daniel Štrobl — Herečka Antonie Martinec Formanová — Globální tíseň

Budoucnost Česka

Svět budoucnosti: Zuzana Čaputová a Petr Pavel — Portrét učitele Tomáše Brettla — Politika budoucnosti: Kryštof Jiřík a Adéla Gjuričová — Ze studentského nápadu až na americký trh: podnikatel Lukáš Brchl — Byznys budoucnosti: Radek Špicar a Laureen Höllge — Portrét filmařky Diany Cam Van Nguyen — Budoucnost Česka

Svoboda slova

Svoboda názoru: Věra Jourová a Ivan Bartoš — Nepublikované versus publikované záznamy ČST z Palachova týdne — Svoboda projevu: Jiří Přibáň a Radka Denemarková — Socialističtí novináři ve službách mocných — Svoboda médií: Karel Hvížďala a Laura Kellö Kalinská — Jak tehdejší propaganda vykreslovala skupinu The Plastic People of the Universe — Svoboda slova